微软最新策略揭秘:利用儿童故事培育AI语言模型,低成本训练革命即将开启

在人工智能领域,理解和改进神经网络的行为一直是一个挑战。大型语言模型如ChatGPT的训练成本高昂,而微软研究人员提出了一个新的方法:使用儿童故事来训练微小模型。以此模拟神经网络的学习过程。

这种方法的灵感来自于果蝇基因组测序与人类基因组测序的类比。研究人员在较小的数据集上训练语言模型,从而更容易理解这些模型的行为。在最新的研究成果中,微软的研究人员发现。即使是比现有最先进系统小数千倍的语言模型,在接受儿童故事训练后,也能迅速学会讲述连贯且符合语法的故事。

为了生成这些训练数据,研究人员首先创建了一个由大型语言模型生成的合成儿童故事库。然后,他们使用这些故事训练了参数规模介于100万到3000万的模型,并比较了它们的性能。结果表明,较小的模型也能表现出色,尤其是在掌握语法和故事一致性方面。

这项研究表明,微小模型的成功为训练更大、更复杂的模型提供了宝贵的见解。同时,它也为如何构建高质量的训练数据集提供了新的思路。研究人员希望,这一发现能激发更多关于语言模型的科学研究。

和讯自选股写手

风险提示:以上内容仅作为作者或者嘉宾的观点,不代表和讯的任何立场,不构成与和讯相关的任何投资建议。在作出任何投资决定前,投资者应根据自身情况考虑投资产品相关的风险因素,并于需要时咨询专业投资顾问意见。和讯竭力但不能证实上述内容的真实性、准确性和原创性,对此和讯不做任何保证和承诺。

领和讯Plus会员,免费看更多独家内容:8大财经栏目,最新最热资讯干货独家行情解读,快人一步掌握市场投资风向。

微软最新策略揭秘:利用儿童故事培育AI语言模型,低成本训练革命即将开启相关教程

-

蔡崇信预言成真?微软AI扩张版图背后的故事揭秘

蔡崇信预言成真?微软AI扩张版图背后的故事揭秘2024-08-29

-

间接承认Win11“很渣”?微软开启长期“白嫖策略”:真相揭秘

间接承认Win11“很渣”?微软开启长期“白嫖策略”:真相揭秘2023-09-27

-

微软将培训10万名印度开发者,掌握人工智能技术

微软将培训10万名印度开发者,掌握人工智能技术2024-01-09

-

微软全球技术大会发布自研芯片Athena,降低AI开发成本

微软全球技术大会发布自研芯片Athena,降低AI开发成本2023-11-15

-

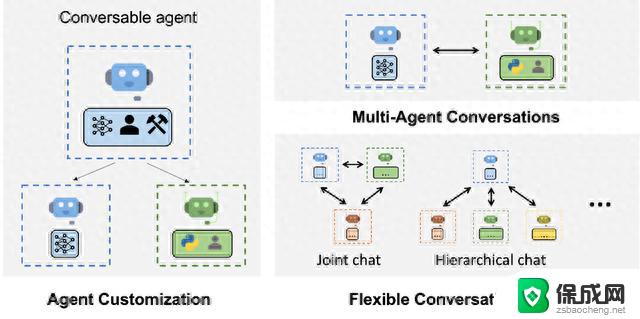

微软推出AutoGen框架,助力开发者打造基于大语言模型的复杂应用

微软推出AutoGen框架,助力开发者打造基于大语言模型的复杂应用2023-09-29

-

微软、谷歌等巨头承诺推出生成式AI发展措施,助力保护儿童健康

微软、谷歌等巨头承诺推出生成式AI发展措施,助力保护儿童健康2024-04-24

- 微软彻底失败?索尼成为游戏界霸主?微软应重新规划策略!

- 微软服务器沉海底与华为挖空大山:科技创新背后的故事揭秘

- 比尔·盖茨:微软帝国的缔造者与慈善事业先驱,揭秘其成功背后的秘密

- Windows断供!华为电脑生死存亡?12月鸿蒙革命即将上演必读

- 英伟达还能牛多久?2021年英伟达最新动态及未来发展趋势分析

- 如何有效升级显卡以提升游戏性能和图形质量:详细教程和实用技巧

- 英伟达中国打造国产GPU,摩尔线程冲刺IPO,估值超255亿

- 详细教程:Win10系统激活的多种方法与步骤,最新有效激活方法大揭秘

- 微软下跌1.41%,报416.59美元/股,市值跌破2.5万亿美元

- 详细步骤教你如何在Win7系统中进行系统还原,轻松恢复系统设置

新闻资讯推荐

- 1 微软下跌1.41%,报416.59美元/股,市值跌破2.5万亿美元

- 2 详细步骤教你如何在Win7系统中进行系统还原,轻松恢复系统设置

- 3 聊聊游戏本该怎么选择CPU(处理器):如何挑选最适合游戏的处理器?

- 4 AMD致命一击 将在移动平台上3D缓存,提升游戏体验

- 5 初探微软Win10/Win11新版Terminal,AI提升终端命令体验,全面解析最新终端技术革新

- 6 2024年11月CPU横评及选择推荐指南:最新CPU性能排名及购买建议

- 7 英伟达现在为什么甩AMD几条街了?来看看原因-详细分析两家公司的竞争优势

- 8 英伟达盘中超越苹果,再次成为全球市值最高公司,市值超过2.3万亿美元

- 9 微软宣布Win10系统将退休,如何应对升级问题?

- 10 微软上涨1.25%,报411.435美元/股,市值再创新高

win10系统推荐

系统教程推荐

- 1 惠普笔记本电脑如何重装系统win10 惠普笔记本如何重装win10系统教程

- 2 win11怎样调出分屏 笔记本如何实现分屏显示

- 3 win11如何设置不休眠 Win11电脑不休眠设置方法

- 4 来电对方听不到声音,我听得到怎么回事 手机通话时对方听不到我的声音怎么办

- 5 word怎么改名字 Office用户名如何修改

- 6 电脑怎么样添加打印机 Win10正式版如何添加打印机驱动

- 7 一插电源电脑就自动开机 电脑接通电源后自动开机怎么办

- 8 微软surface人脸识别怎么设置 面部识别设置安全性

- 9 0xc0000225 win10 修复 Windows 10 错误代码0xC0000225修复方法

- 10 win7台式系统重装 我的台式电脑如何重新安装win7系统