NVIDIA Blackwell AI服务器订单量25%,超微获得巨额订单

在人工智能的热潮中,SMCI(超微计算机公司)在相当长的一段时间里都是市场的头条新闻。该公司不仅股价表现优异,同比增长 182%,而且还成功地与英伟达(NVIDIA)建立了合作关系,成为市场的焦点。SMCI 专注于专为人工智能工作负载设计的高性能服务器和存储系统,在过去几个季度里,订单大量涌入。

现在,该公司正寻求将其业务扩展到更先进的NVIDIA Blackwell AI GPU 架构,因为有报道称超微计算机公司已经收到了以 Blackwell 为核心的 AI 服务器机架的巨额订单。台湾《经济日报》报道称,超微计算机公司(SMCI)准备出货 25% 的英伟达(NVIDIA)基于 GB200 的 Blackwell AI 服务器,总量将达到 10000 台以上。这一次,NVIDIA似乎赋予了 SMCI 更多的责任,如果进展顺利,最终将转化为巨大的经济效益。这些系统包括:

NVIDIA HGX B100 8-GPU 和 HGX B200 8-GPU 系统

包含 10 个 GPU 的 5U/4U PCIe GPU 系统

SuperBlade 在 8U 机柜中最多可配备 20 个 B100 GPU,在 6U 机柜中最多可配备 10 个 B100 GPU

2U Hyper 最多可配备 3 个 B100 GPU

配备最多 4 个 B100 GPU 的 Supermicro 2U x86 MGX 系统

为了与富士康和广达等巨头竞争,SMCI 决定积极拓展供应链,将 Argosy Research 和 Auras Technology 等公司纳入其中。自今年年初以来,该公司已经积累了NVIDIA公司的Blackwell GB200 AI GPU,以确保供应链流程顺畅,最终保证在竞争中占据优势。此外,超微计算机公司已经在水冷要件方面进行了投资,据说这对较新的 Blackwell AI 服务器至关重要。以下是超微服务器阵容的部分特点:

超微公司的NVIDIA HGX B200 8GPU 风冷和液冷系统可实现最高的生成式人工智能训练性能。该系统采用 8 个英伟达 Blackwell GPU,通过第五代 NVLink 与 1.5TB 高带宽内存池(速度达 60TB/s)连接,以加快人工智能训练工作负载的速度。

超微最畅销的人工智能训练系统--配备NVIDIA HGX H100/H200 8-GPU 的 4U/8U 系统,将支持英伟达即将推出的 HGX B100 8-GPU。

超微机架级解决方案采用 GB200 Superchip 系统作为服务器节点,每个节点配备 2 个 Grace CPU 和 4 个 NVIDIA Blackwell GPU。超微的直接到芯片液冷技术最大限度地提高了密度,在一个 44U ORV3 机架上可安装 72 个 GB200 192GB GPU(每个 GPU 的 TDP 为 1200W)。

由此看来,SMCI 希望这次以更积极的方式回归,通过与NVIDIA的密切关系,只要他们能保持供应链和产品质量,就可以继续保持现有的市场地位。

NVIDIA Blackwell AI服务器订单量25%,超微获得巨额订单相关教程

-

word审阅模式修订怎么打开 word审阅修订的快捷键

word审阅模式修订怎么打开 word审阅修订的快捷键2024-01-22

-

微软苹果欧盟反垄断指控:科技巨头或面临巨额罚款风险

微软苹果欧盟反垄断指控:科技巨头或面临巨额罚款风险2024-06-26

-

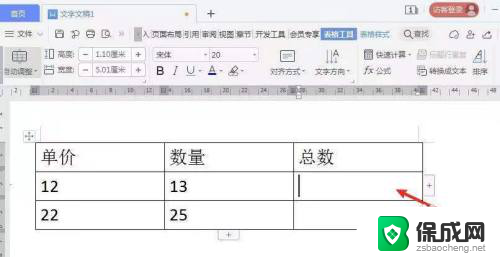

word合计=单价×数量怎么算 计算表格的单价和数量

word合计=单价×数量怎么算 计算表格的单价和数量2024-01-02

-

微软继续将游戏移植到PS5,新款Xbox即将上市,预订开放

微软继续将游戏移植到PS5,新款Xbox即将上市,预订开放2024-08-24

-

英雄连2怎么获得金币 英雄连2如何获得金币

英雄连2怎么获得金币 英雄连2如何获得金币2023-12-13

-

微软、谷歌,“服软”了!全球科技巨头纷纷向微软和谷歌低头

微软、谷歌,“服软”了!全球科技巨头纷纷向微软和谷歌低头2023-11-15

- windows10怎么搭建ftp服务器 win10 ftp服务器搭建详细教程

- 微软Windows 12系统继续免费升级!不会搞云订阅,用户可享受免费升级的最新系统

- 报道称CMA7月时就已批准微软收购 拿名单任微软挑选:CMA批准微软收购,微软挑选名单曝光

- Statcounter:微软Edge桌面浏览器市场份额近13% - Edge浏览器市场份额持续增长

- 英伟达还能牛多久?2021年英伟达最新动态及未来发展趋势分析

- 如何有效升级显卡以提升游戏性能和图形质量:详细教程和实用技巧

- 英伟达中国打造国产GPU,摩尔线程冲刺IPO,估值超255亿

- 详细教程:Win10系统激活的多种方法与步骤,最新有效激活方法大揭秘

- 微软下跌1.41%,报416.59美元/股,市值跌破2.5万亿美元

- 详细步骤教你如何在Win7系统中进行系统还原,轻松恢复系统设置

新闻资讯推荐

- 1 微软下跌1.41%,报416.59美元/股,市值跌破2.5万亿美元

- 2 详细步骤教你如何在Win7系统中进行系统还原,轻松恢复系统设置

- 3 聊聊游戏本该怎么选择CPU(处理器):如何挑选最适合游戏的处理器?

- 4 AMD致命一击 将在移动平台上3D缓存,提升游戏体验

- 5 初探微软Win10/Win11新版Terminal,AI提升终端命令体验,全面解析最新终端技术革新

- 6 2024年11月CPU横评及选择推荐指南:最新CPU性能排名及购买建议

- 7 英伟达现在为什么甩AMD几条街了?来看看原因-详细分析两家公司的竞争优势

- 8 英伟达盘中超越苹果,再次成为全球市值最高公司,市值超过2.3万亿美元

- 9 微软宣布Win10系统将退休,如何应对升级问题?

- 10 微软上涨1.25%,报411.435美元/股,市值再创新高

win10系统推荐

系统教程推荐

- 1 win11打开应用的确认怎么关闭 Win11取消软件打开时的确认提示

- 2 win10调鼠标灵敏度 win10鼠标灵敏度设置方法

- 3 华为手机自动整理桌面图标 华为手机快速整理桌面应用的方法

- 4 电脑音箱声音办 电脑插上音箱却没有声音怎么处理

- 5 惠普笔记本电脑如何重装系统win10 惠普笔记本如何重装win10系统教程

- 6 win11怎样调出分屏 笔记本如何实现分屏显示

- 7 win11如何设置不休眠 Win11电脑不休眠设置方法

- 8 来电对方听不到声音,我听得到怎么回事 手机通话时对方听不到我的声音怎么办

- 9 word怎么改名字 Office用户名如何修改

- 10 电脑怎么样添加打印机 Win10正式版如何添加打印机驱动